Wer mich kennt, weiss: Ich habe grundsätzlich einen hohen Glauben – und auch ein grosses Vertrauen – in künstliche Intelligenz. Gerade wenn es um Zahlen geht. Maschinen können per se besser rechnen als wir Menschen. Sie sind konsequenter im Analysieren, im Vergleichen von Dokumenten und in der Verarbeitung grosser Datenmengen. Dinge, bei denen uns Menschen durchaus mal etwas durchrutscht.

Umso spannender war für mich die Erfahrung, KI ganz konkret im Rahmen unserer Jahresabschlüsse für Kunden und Verbände einzusetzen.

Vertrauen ist gut, Kontrolle ist besser – oder doch nicht?

Der Satz „Vertrauen ist gut, Kontrolle ist besser“ war mir ehrlich gesagt schon immer ein wenig zuwider. Vor allem in der Zusammenarbeit mit Menschen und im Team. Er trägt einen Kern von Misstrauen in sich, der meiner Haltung widerspricht.

Entweder ich vertraue darauf, dass jemand seine Arbeit nach bestem Wissen und Gewissen erledigt – oder ich tue es nicht. Und wenn Fehler passieren, dann meist nicht aus bösem Willen, sondern weil etwas übersehen wurde, weil Zeitdruck herrschte oder weil Erfahrung (noch) fehlt. Dazu kann man stehen. Fehler darf und soll man kommunizieren.

Auch wir haben im ersten Firmenjahr genügend solcher Fehler gemacht. Neue Verbände, neue Prozesse, neue Systeme, ein neues Team – da entstehen zwangsläufig Missverständnisse an Schnittstellen oder falsche Annahmen. Entscheidend war für mich immer, Verantwortung zu übernehmen, mich zu entschuldigen und daraus zu lernen.

Der Versuch: Jahresabschluss mit Unterstützung von KI

Genau mit dieser offenen Haltung habe ich mich – zusätzlich zu unseren Fachleuten aus der Buchhaltung – auf ein Experiment eingelassen: Wie weit kommt eine KI beim Jahresabschluss?

Wichtig dabei:

Wir haben professionelle, bezahlte KI-Lösungen eingesetzt, die lokal in unserem System laufen. Die KI hatte Zugriff auf alle relevanten Unterlagen (über 100 für einen Jahresabschluss):

- Konten- und Kostenstellenbewegungen

- Debitoren- und Kreditorenlisten

- Projektabrechnungen

- Statuten, Reglemente und weitere normative Dokumente

Die Ausgangslage war also solide. Und da ich unsere Zahlen und Bewegungen recht gut kenne, konnte ich relativ einfach überprüfen, ob die Resultate plausibel waren.

Wir haben mehrere KI-Modelle verglichen

Damit es nicht bei einem Einzelfall bleibt, haben wir bewusst mit verschiedenen KI-Systemen gearbeitet – und die Resultate jeweils gegeneinander gespiegelt. Die Idee war simpel: Wenn ein Modell etwas anders auswertet als das andere, fällt schneller auf, wo Halluzinationen, Interpretationen oder schlicht Rechen- und Zuordnungsfehler passieren.

Die Quintessenz: Beide haben Fehler gemacht – teilweise bis hin zu völligem Unsinn. Immerhin nicht immer derselbe. Das machte den Vergleich zwar hilfreich, aber auch ernüchternd: Die unterschiedlichen Systeme lieferten oft einfach unterschiedliche Arten von Fehlern.

Das Ergebnis: ehrlich gesagt erschütternd

Ich hätte erwartet, dass gerade bei klar strukturierten Zahlen, Konten und Kostenstellen eine Maschine sauber arbeitet. Doch das Gegenteil war der Fall.

Es gab keine einzige Auswertung, die im ersten Anlauf auch nur annähernd korrekt war.

Noch irritierender war: Die Schlusszahlen – also die Totalen in Bilanz, Erfolgsrechnung, Kostenstellenabrechnungen, Mitgliederrechnungen usw. – stimmten oft. Sie waren in sich konsistent, das heisst: Die Summen gingen rechnerisch auf. Doch die einzelnen Positionen, aus denen diese Totalen angeblich bestanden, waren teilweise frei erfunden. Gemerkt habe ich das nur, weil ich die Grössenordnungen kenne und ein Gefühl dafür habe, was in einer bestimmten Zeile realistischerweise stehen müsste.

Die KI füllte Lücken mit erfundenen Zahlen, nur damit die Rechnung am Ende aufgeht.

Ein Beispiel:

Eine grosse Spitalgruppe tauchte plötzlich mit einem Beitrag von 12’000 Franken auf. Klingt plausibel – wenn man weiss, dass es eine grosse Institution ist. Nur: Wir stellen solchen Organisationen gar keine Rechnungen in dieser Höhe. Das wusste ich. Die KI offenbar nicht – respektive sie sollte es wissen und entschied sich trotzdem für eine „plausible“ Zahl.

Besonders spannend war:

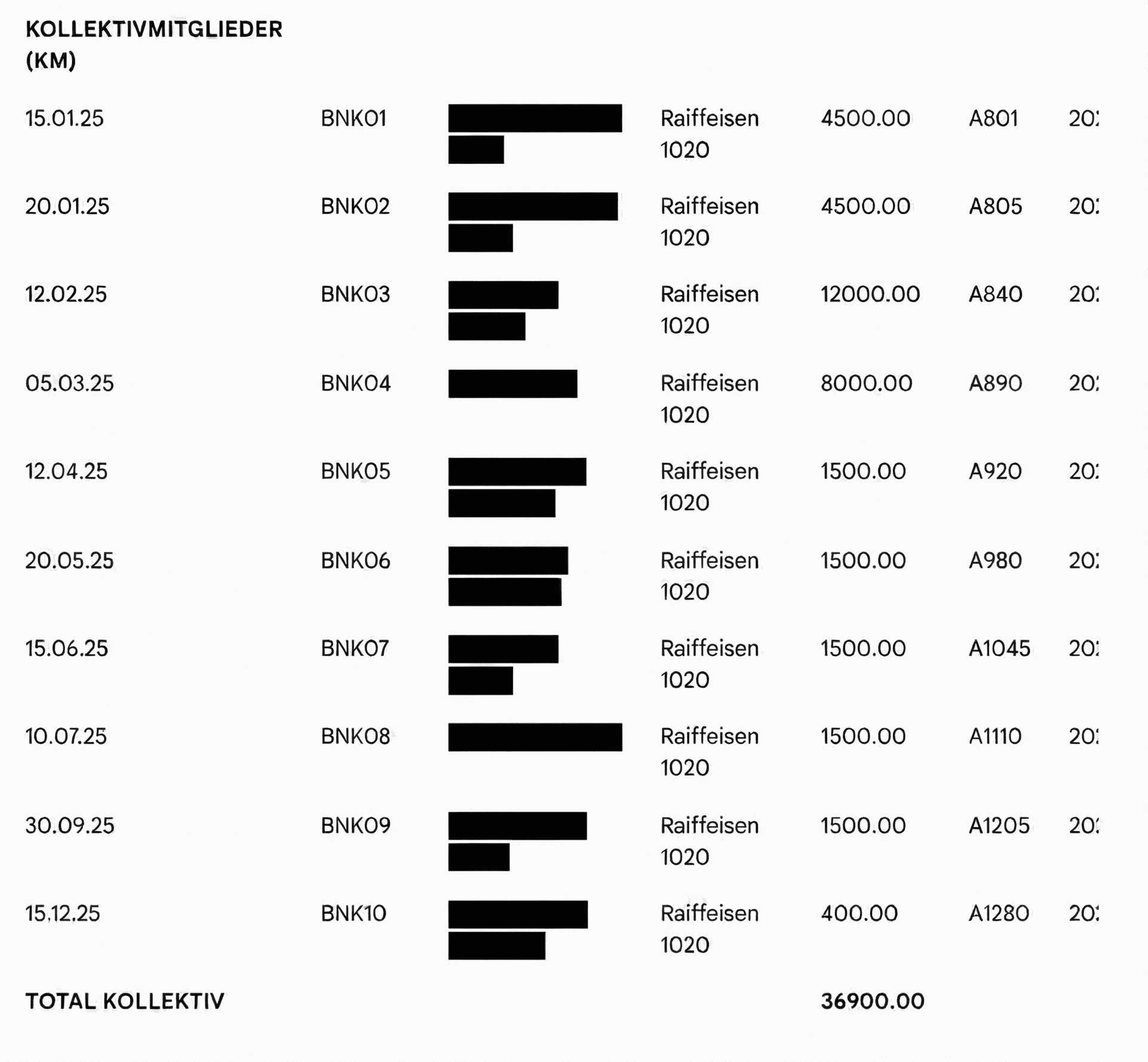

Obwohl der KI die Statuten und Reglemente vorlagen, aus denen klar hervorgeht, wie hoch Kollektivmitgliederbeiträge sind, erfand sie plötzlich entsprechende Beiträge oder führe Institutionen auf, welche nicht Kollektivmitglied sind. Oder sie zog andere Beiträge aus dem Sponsoring dazu. Diese tauchten dann auf falschen Konten auf – vermischt mit regulären Mitgliederbeiträgen.

Was ich daraus gelernt habe

Zwei zentrale Erkenntnisse:

-

Bei KI gilt das Prinzip „Vertrauen ist gut, Kontrolle ist besser“ ganz besonders.

Ganz sicher mehr als bei Menschen. -

KI ist kein Ersatz für fachliche Verantwortung.

Sie kann unterstützen, strukturieren, zusammenfassen – aber sie versteht den Kontext nicht so, wie wir es oft annehmen.

Und noch etwas Positives:

Durch dieses Experiment habe ich selbst unglaublich viel gelernt. Ich habe mich nochmals viel tiefer mit unseren Zahlen, mit Buchhaltungslogiken und mit typischen Fehlerquellen in Jahresabschlüssen auseinandergesetzt. Die investierten Stunden waren also keineswegs verloren – im Gegenteil: Sie haben mein eigenes Fachwissen deutlich geschärft.

Mein Fazit

Danke, liebe KI, dass du so schlecht gearbeitet hast.

Denn genau dadurch durfte ich sehr viel lernen.

KI bleibt für uns dennoch ein wichtiges Werkzeug – aber eines, das klare Grenzen hat. Gerade im sensiblen Bereich von Finanzen, Verantwortung und Vertrauen braucht es weiterhin menschliche Erfahrung, kritisches Denken und Kontrolle.

schreiben …